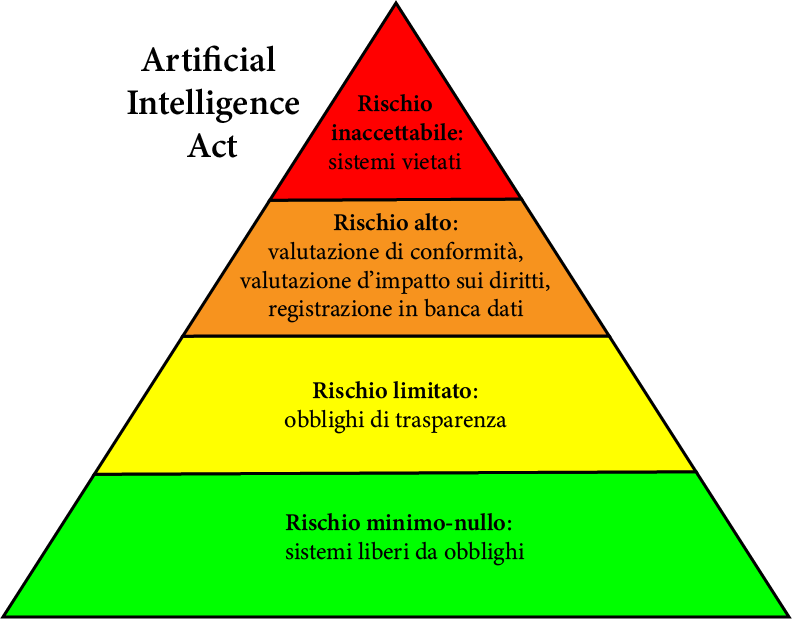

Dal rischio inaccettabile al rischio alto, a quello limitato fino a quello minimo-nullo. È su questa rigorosa gerarchia del livello di rischio che si basa l’Artificial Intelligence Act (AI Act), approvato dal Consiglio dell’Unione europea (Ue) il 21 maggio 2024 a seguito dell’approvazione del Parlamento europeo. È il primo tentativo al Mondo di stabilire norme armonizzate per lo sviluppo e l’uso di sistemi basati sull’intelligenza artificiale.

Ciò che distingue l’AI Act da altre iniziative normative è il suo carattere giuridicamente vincolante, ovvero il carattere di legge dura, a differenza di precedenti iniziative di autoregolamentazione, vale a dire iniziative di soft law in materia di etica dell’Intelligenza Artificiale (IA).

Il concetto di base è che, maggiore è il rischio, più rigorose sono le regole e le responsabilità a cui deve sottostare chi sviluppa o fornisce sistemi di IA. Fino al punto che se il pericolo è inaccettabile le applicazioni non possono essere autorizzate.

Abbiamo chiesto a Enrico Maestri, docente di diritto informatico, di metodologia e logica giuridica e di etica e diritto dell’intelligenza artificiale presso l’Università di Ferrara, di analizzare per noi l’impianto generale della legge, gli elemento di novità, i vantaggi e i limiti della nuova normativa. Fra questi ultimi, Maestri segnala anzitutto che “ è evidente che l’AI Act dia priorità all’economia, agli affari e all’innovazione rispetto alle preoccupazioni morali e che i diritti umani siano considerati solo marginalmente”.

Nel dossier troverete anche il contributo di Elena Guerra, esperta di etica robotica e dottoranda in ingegneria meccanica e industriale all’università di Brescia. L’attenzione della studiosa si concentra in particolare sul tema fondamentale della responsabilità etica.

La legge prevede, almeno in parte, che bisognerà rendere leggibili i black box model, quei sistemi simili a delle scatole nere di cui si vedono solamente i risultati, rendendo esplicite ex ante le decisioni che stanno alla base di quel modello per consentire, anche al di fuori dell’azienda produttrice, in caso di criticità, di rivisitare gli algoritmi. Dal punto di vista etico, particolarmente problematici sono campi di applicazione come il rapporto medico paziente e l’amministrazione della giustizia.

Ci sono poi problemi di formazione che, soprattutto in questi casi, richiede tempi abbastanza lunghi. In generale si paventa anche il rischio che una fascia di popolazione non sufficientemente coinvolta e adeguatamente formata venga marginalizzata e che l’uso dell’IA diventi elitario.

Irene Fabbri e Marco Roma affrontano il problema della difficoltà di definire e regolamentare una tecnologia in corsa che riguarda sistemi fra loro molto diversi. Nella prima versione del testo europeo, il problema era stato affrontato stilando un elenco di tecnologie che sarebbero state oggetto della legge. Tuttavia, il dubbio che l’AI Act potesse diventare obsoleto in breve tempo ha portato L’Europa a scegliere poi una definizione più ampia, concettuale, e tecnologicamente “neutra”.

Nel testo che segue abbiamo sintetizzato e schematizzato i passaggi e gli argomenti centrali del testo di Maestri

La gerarchia dei livelli di rischio che costituisce l’ossatura dell’AI Act può essere schematizzata come una piramide, alla sommità della quale ci sono i sistemi vietati perché caratterizzati da un rischio inaccettabile.

Mano a mano che si scende, il rischio diminuisce e si stabiliscono per ogni livello le norme specifiche e i vincoli perché i sistemi siano accettati. Come suggerisce la figura geometrica, i sistemi vietati sono pochi, e molti quelli liberi da obblighi.

Sistemi IA a rischio inaccettabile: sono vietati, con eccezioni limitate e regolate

L’AI Act ha innanzitutto vietato l’utilizzo di tecniche subliminali deliberatamente manipolative o ingannevoli con l’obiettivo di distorcere il comportamento di una persona, soprattutto se ne sfruttano le vulnerabilità, e l’attribuzione di un punteggio sociale agli individui in base al loro comportamento sociale o alle loro caratteristiche personali, portando a esiti discriminatori (social scoring).

Sono state ritenute inaccettabili anche la profilazione delle persone riguardo al rischio di commettere un crimine, basata esclusivamente sulle loro caratteristiche personali (polizia predittiva), l’estrazione non mirata di immagini facciali da internet o da telecamere a circuito chiuso per la creazione di banche dati, e il riconoscimento delle emozioni sui luoghi di lavoro e di istruzione, eccettuati motivi medici o di sicurezza (ad esempio il monitoraggio della stanchezza di un pilota).

Infine, per quanto riguarda l’utilizzo di dati biometrici (le caratteristiche fisiche univoche come l’impronta digitale e la geometria del volto), sono state proibite la categorizzazione biometrica per dedurre le caratteristiche sensibili (come opinione politica, religione, orientamento sessuale) e l’identificazione biometrica da remoto in tempo reale in spazi accessibili al pubblico (ovvero il riconoscimento facciale da telecamere a circuito chiuso) da parte delle forze dell’ordine.

Quest’ultimo divieto prevede però tre eccezioni: la ricerca di vittime di rapimento o di tratta e di persone scomparse; minacce concrete per la vita e la sicurezza delle persone, come la minaccia di attacchi terroristici; l’identificazione di autori di crimini gravi (tra cui omicidio, stupro, pedopornografia, terrorismo, tratta, traffico di armi illegali o di droga).

In questi casi l’uso dell’identificazione biometrica da remoto deve essere limitato nel tempo e nello spazio all’individuazione del target specifico e preceduto da una valutazione dell’impatto sui diritti dei cittadini, dalla registrazione in una banca dati europea e dall’autorizzazione di un giudice. In casi di urgenza il sistema di identificazione può essere comunque attivato, purché venga richiesta l’autorizzazione entro ventiquattro ore.

Sistemi IA ad alto rischio: sono soggetti a una valutazione di conformità rigorosa

Al di fuori degli utilizzi vietati, l’identificazione biometrica da remoto, la categorizzazione biometrica e il riconoscimento delle emozioni sono state classificate ad alto rischio, assieme all’IA usata per assistere le ricerche giudiziarie, per influenzare gli elettori nelle campagne politiche, per determinare l’accesso a servizi essenziali (come l’assistenza sanitaria), l’affidabilità creditizia delle persone e rischi e prezzi nelle assicurazioni sulla vita e sanitarie.

Sono state ritenute ad alto rischio alcune applicazioni dell’IA in ambito educativo (ad esempio per determinare l’ammissione agli istituti di istruzione e per valutare i risultati dell’apprendimento) e lavorativo (come per valutare i candidati e ottimizzare la gestione dei lavoratori), oltre ai sistemi IA utilizzati come componenti di sicurezza nella gestione delle infrastrutture digitali critiche, del traffico stradale e della fornitura di acqua, gas, riscaldamento ed elettricità.

Infine, l’elenco ad alto rischio comprende anche diverse tecnologie usate dalle forze dell’ordine (ad esempio i poligrafi, le cosiddette macchine della verità, e i sistemi per valutare le prove nel corso di indagini) e dalle autorità di controllo delle migrazioni (come i poligrafi, la profilazione del rischio di immigrazione irregolare e i sistemi per la valutazione delle domande di asilo).

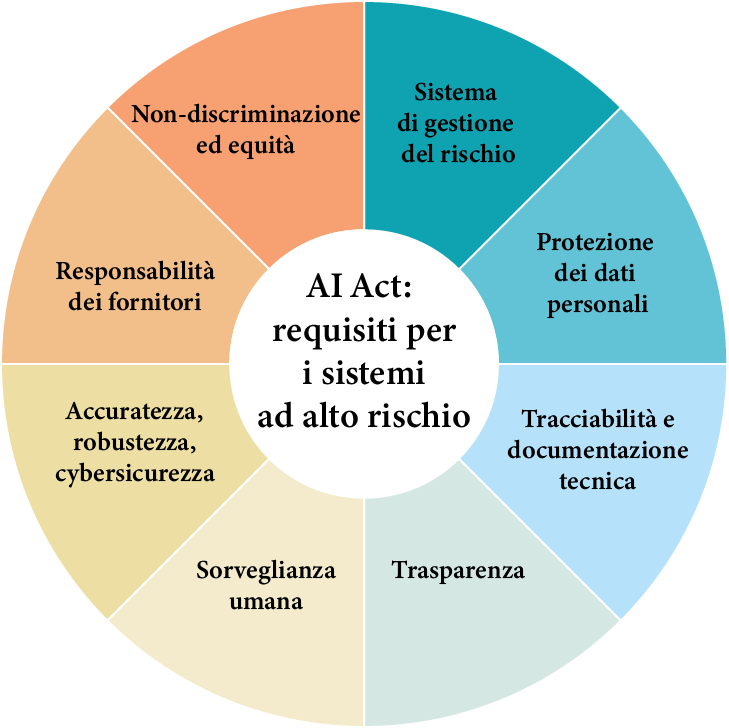

Prima che un sistema ad alto rischio sia immesso sul mercato, il fornitore dovrà sottoporlo a una valutazione di conformità a una serie di requisiti (cybersicurezza, tracciabilità, sorveglianza umana, accuratezza), dimostrare che l’addestramento è avvenuto sulla base di un’alta rappresentatività di dati per evitare discriminazioni, effettuare una valutazione dell’impatto sui diritti fondamentali dei gruppi coinvolti e delle misure di correzione da adottare, e registrarlo in una banca dati pubblica.

Sistemi IA a rischio limitato: sono soggetti a obblighi di trasparenza

I sistemi a rischio limitato includono applicazioni in cui l’obbligo fondamentale è la trasparenza: nel caso di chatbot, ad esempio, l’utente dovrà essere informato del fatto che sta interagendo con una macchina, mentre testi, audio, video e immagini realizzati con l’IA (come i deepfake) dovranno essere contrassegnati come tali. Invece l’utilizzo dei sistemi a rischio minimo o nullo, di fatto la maggior parte di quelli utilizzati in Ue (come nei videogiochi o filtri spam), è libero da obblighi.

I modelli GPAI sono soggetti a obblighi di trasparenza e di valutazione del rischio

I modelli di IA per scopi generali (general purpose artificial intelligence, GPAI), gli algoritmi che sono in grado di svolgere più di un compito, vengono trattati dall’AI Act separatamente, poiché essi non costituiscono propriamente sistemi IA. Tuttavia, un sistema GPAI, basato su uno o più modelli GPAI, può costituire un sistema ad alto rischio o a rischio limitato, ricadendo quindi nei relativi obblighi. Ad esempio, il sistema IA generativo Chat-GPT si basa su più modelli GPAI tra cui GPT-3 (di recente è uscito il modello potenziato GPT-4).

I modelli GPAI, eccetto quelli le cui informazioni sono già rese pubblicamente disponibili con licenza libera, sono soggetti a obblighi di trasparenza, quali la conservazione della documentazione tecnica, in particolare circa i contenuti usati per l’addestramento e la fase di test, e l’elaborazione di una politica sul diritto d’autore che rispetti le leggi dell’Ue.

Tra i modelli GPAI vengono distinti quelli a rischio sistemico, che hanno una capacità computazionale superiore a 1025 FLOPS (floating point operations per second) e che potrebbero avere un alto impatto sulla vita, salute o diritti delle persone, sulle infrastrutture critiche, sulla proprietà o sull’ambiente, per cui un incidente rischierebbe di propagarsi su larga scala a livello di Unione.

In aggiunta agli obblighi di trasparenza, gli sviluppatori di modelli GPAI a rischio sistemico dovranno condurre valutazioni per identificare e mitigare i rischi, assicurare la sicurezza informatica e segnalare immediatamente eventuali incidenti all’autorità competente.

L’approccio basato sul rischio non è abbastanza ambizioso nella protezione dei diritti umani

Nonostante durante la negoziazione, su richiesta del Parlamento, gli elenchi dei sistemi vietati e ad alto rischio siano stati ampliati rispetto alla proposta originale, e nonostante gli stessi elenchi siano modificabili (pur con un iter complesso) per seguire lo sviluppo dell’IA, secondo diversi esperti e organizzazioni civili l’AI Act non è stato abbastanza ambizioso nel proteggere i diritti fondamentali.

Infatti, i sistemi IA ad alto rischio utilizzati dalle forze dell’ordine e dalle autorità di controllo delle migrazioni verranno registrati in una sezione non pubblica nella banca dati, e la stessa banca dati non includerà i sistemi a rischio limitato, che quindi saranno soggetti a una sotto-regolamentazione pur potendo avere un forte impatto sulla società (come i deepfake). Inoltre, gli Stati potranno esentarsi dall’AI Act per ogni questione considerata di “pubblica sicurezza” e le tecnologie prodotte in Ue ma esportate in Paesi terzi non dovranno rispettare gli obblighi definiti dalla legge.

Le organizzazioni per i diritti umani chiedono che tutti i sistemi di identificazione e categorizzazione biometrica, di riconoscimento delle emozioni e quelli usati nell’ambito delle migrazioni vengano vietati, che le autovalutazioni del rischio effettuate dai fornitori vengano sostituite da valutazioni svolte da enti indipendenti, e che sia rafforzata l’efficacia del diritto di reclamo.

A questo proposito, Maestri afferma: “i diritti fondamentali compaiono raramente nel testo principale; l’obiettivo principale dell’AI Act sembra essere maggiormente focalizzato sui mercati e sull’accesso al mercato dei sistemi di intelligenza artificiale. […]. l’AI Act lascia una vasta gamma di sistemi di intelligenza artificiale non regolamentati, nonostante possano avere un impatto grave sui diritti fondamentali”. E sul punto cruciale della valutazione del livello di rischio e controllo da parte di soggetti terzi rispetto ai produttori, sottolinea: “ La sorveglianza di mercato da parte delle autorità degli Stati membri avviene solo a posteriori, non preventivamente. Questo processo viene eseguito dal fornitore stesso, e non da un terzo indipendente, esterno.

Di conseguenza, l’approccio proposto lascia la valutazione preliminare del rischio, compresa l’identificazione dei sistemi di intelligenza artificiale ad alto rischio, al fornitore e allo sviluppatore, concedendo loro un ampio margine di discrezionalità”.