L’AI Act è la nuova legge europea che, prima al Mondo, regola l’Intelligenza Artificiale (IA), ma sotto a questo termine vengono a trovarsi una molteplicità di strumenti tecnologici estremamente diversi tra loro. Ad oggi, se si pensa all’IA vengono subito in mente i sistemi generativi, che servono per creare nuovi contenuti. Ne sono un esempio celebre ChatGPT o il rivale Gemini, che sono strumenti in grado di generare testo a seguito di richieste (prompt) che l’utente invia con un sistema che imita una chat di messaggistica. Ci sono poi anche quelle IA generative che servono per la generazione di immagini, come Midjourney e Dall-e. Non bisogna però dimenticare che quelle generative sono solo una sottocategoria nel panorama tecnologico dell’IA.

Quando si parla di Intelligenza Artificiale infatti ci si riferisce anche a una serie di altri strumenti, volendo citare alcuni esempi: gli assistenti virtuali (come Siri e Alexa), le automobili a guida autonoma, i sistemi di raccomandazione (come la funzione di suggerimento titoli in Netflix e Amazon Prime Video), i sistemi antispam, i sistemi di riconoscimento biometrico, che identificano e autenticano gli individui in base ai tratti biologici somatici (come il riconoscimento facciale usato per sbloccare gli smartphone) e molto altro.

Non solo, l’avanzamento tecnologico in questo ambito corre velocissimo e la regolamentazione rischia di essere sempre un passo indietro.

L’AI Act è stato approvato lo scorso 21 maggio ma entrerà in vigore il ventesimo giorno successivo alla pubblicazione nella Gazzetta ufficiale dell’Unione europea (UE) e sarà pienamente applicabile solo dopo ventiquattro mesi da quella data. Fra le difficoltà incontrate nella stesura del testo, sicuramente una è stata il dover dare una definizione di Intelligenza Artificiale, che stabilisse un frame di applicazione della nuova normativa.

Difficile fornire una definizione stabile e universale

Nella prima versione del testo il problema era stato affrontato stilando un elenco di tecnologie che sarebbero state oggetto della legge. Tuttavia, il dubbio che l’AI Act potesse diventare obsoleto in breve tempo ha portato L’Europa a scegliere poi una definizione più ampia, concettuale, e tecnologicamente ‘neutra’.

Si legge quindi nel testo approvato che un sistema di IA è “un sistema basato su macchine e progettato per operare con diversi livelli di autonomia e che può mostrare adattività dopo l’implementazione, deducendo, dagli input ricevuti, in che modo generare output come previsioni, contenuti, raccomandazioni o decisioni che possono influenzare ambienti fisici o virtuali”.

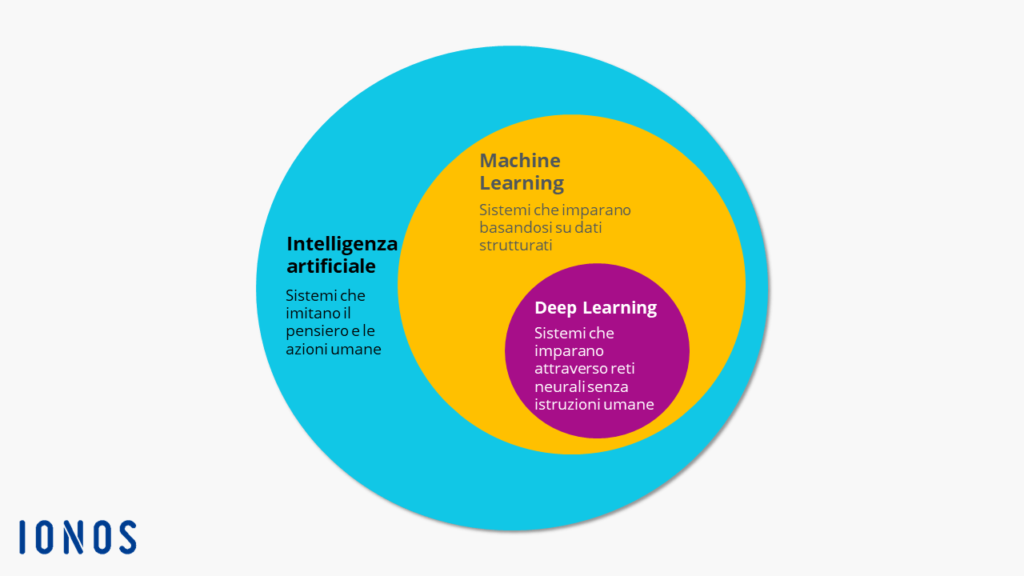

Vengono quindi dati come elementi distintivi degli strumenti di IA le caratteristiche di autonomia e adattività, di cui sicuramente sono un esempio i modelli basati sull’apprendimento. In questo ambito risulta particolarmente rilevante il Machine Learning (ML), un insieme di tecniche e algoritmi che permettono ai computer di “apprendere” a partire dai dati, individuando caratteristiche generali che poi permettono di fare previsioni o prendere decisioni anche su input nuovi, emulando le capacità cognitive dell’uomo. Una nota branca del ML è il Deep Learning (DL), che in particolare utilizza le reti neurali per l’allenamento dei modelli.

Le potenziali applicazioni per i sistemi IA sono innumerevoli e spaziano in maniera trasversale in ogni ambito. Pensiamo alle applicazioni nel campo della medicina dove si cerca di prevedere con anticipo il decorso di una malattia a partire dai dati del paziente, oppure nel campo della cyber security per riconoscere e fermare possibili attacchi. Ha enormi potenzialità anche nel campo della logistica, ad esempio nel prevedere la domanda di un prodotto sul mercato e di conseguenza adattare prezzi o scorte di magazzino, ma anche nella robotica e nella mobilità autonoma dove è fondamentale reagire in tempi rapidissimi alle condizioni del mondo reale.

In uno scenario così complesso e variegato, per regolamentare delle macchine che “possono influenzare ambienti fisici o virtuali” operando con un certo “livello di autonomia”, va tenuto conto che i sistemi di IA non sono immuni da errori. Ad esempio, i sistemi allenati a svolgere il loro “mestiere” utilizzando dati reali, sono inevitabilmente soggetti a tutti i bias (pregiudizi) già presenti nella nostra società. Inoltre, a causa della complessità dei modelli di Machine Learning, gli studiosi si trovano ad affrontare anche problemi di explainability, ovvero difficoltà nel rendere esplicite le logiche per cui dato un certo input si riceve un determinato set di output.

Considerato questo, l’AI Act regolamenta i sistemi di IA basandosi su una valutazione del rischio che possono comportare e non sulle tecnologie che li compongono.

Sebbene ci sia sostegno per la normativa, non mancano richieste di modifica da parte di vari stakeholder, fra cui “l’ampliamento dell’elenco dei sistemi di IA vietati e ad alto rischio, una migliore protezione dei diritti fondamentali, il rafforzamento dei sistemi di governance e meccanismi di ricorso e garantire un adeguato controllo democratico e giudiziario dell’attuazione dell’AI Act.” come indicato da, Enrico Maestri, docente di diritto informatico, di metodologia e logica giuridica e di etica e diritto dell’intelligenza artificiale presso l’Università di Ferrara.

Regolamentare concentrandosi sul caso d’uso e non sulla tecnologia utilizzata

“Pensando a modelli di IA installati su veicoli a guida autonoma – afferma Riccardo Zese, docente di IA presso l’Università di Ferrara – risulta subito chiaro come questi possano produrre danni anche gravi creando incidenti stradali.”

“Il ‘dilemma etico del carrello’ è un utile esempio per chiarire la discussione su questo caso- afferma Zese. Si pensi a un autista di tram che sta conducendo un carrello sulle rotaie. Il carrello non può frenare e sta approcciando uno scambio. Dopo lo scambio, lungo un binario sono state legate cinque persone mentre sul secondo binario solo una. Il conducente deve decidere quale binario prendere e quindi quante persone investire.

In letteratura si possono trovare molte varianti, ma se applichiamo il problema a un veicolo a guida autonoma, dal punto di vista legale si pongono molte domande riguardo alle responsabilità e su quali figure questa debba ricadere.

Appare quindi subito chiara la necessità di processo virtuoso che porti a una regolamentazione, definita in collaborazione con esperti del settore dell’IA, che specifichi limiti e responsabilità derivanti dall’uso di queste tecnologie.”

Visto il rapido sviluppo delle tecnologie, come è possibile, allora, una loro efficace regolazione? “Non si può pensare di regolamentare la specifica metodologia – afferma Zese-. Serve invece regolamentare le applicazioni e i metodi di utilizzo, concentrandosi sul caso d’uso e non sulla tecnologia utilizzata.

L’IA è uno strumento, come può essere un martello o un coltello. Mantenendo l’esempio del martello, le leggi devono definire le sue caratteristiche principali, senza entrare nel dettaglio ad esempio del materiale o del peso, e devono regolamentarne l’uso, perché non venga usato per ferire. Allo stesso modo le IA sono strumenti, serve dare una definizione generale che permetta di identificarle e regolamentarne l’uso, non la tecnologia usata.